Mitä uutismediassa tiedetään tapahtuvan generatiivisen tekoälyn saralla vuoden sisällä, ja mitä mahdollisesti tapahtuu pidemmällä aikavälillä? Ensiksi mainittu jo tiedetään. Viimeksi mainittu vaikeampi. Isoin kysymys liittyy luovuuteen ja erottuvuuteen.

Teknologia mahdollistaa jo nyt monia asioita, mutta kaikkea ei kannata vain sen vuoksi tehdä, jottei luottamus vaarannu. Muuten voi käydä kuten italialaiselle Il Fogliolle.

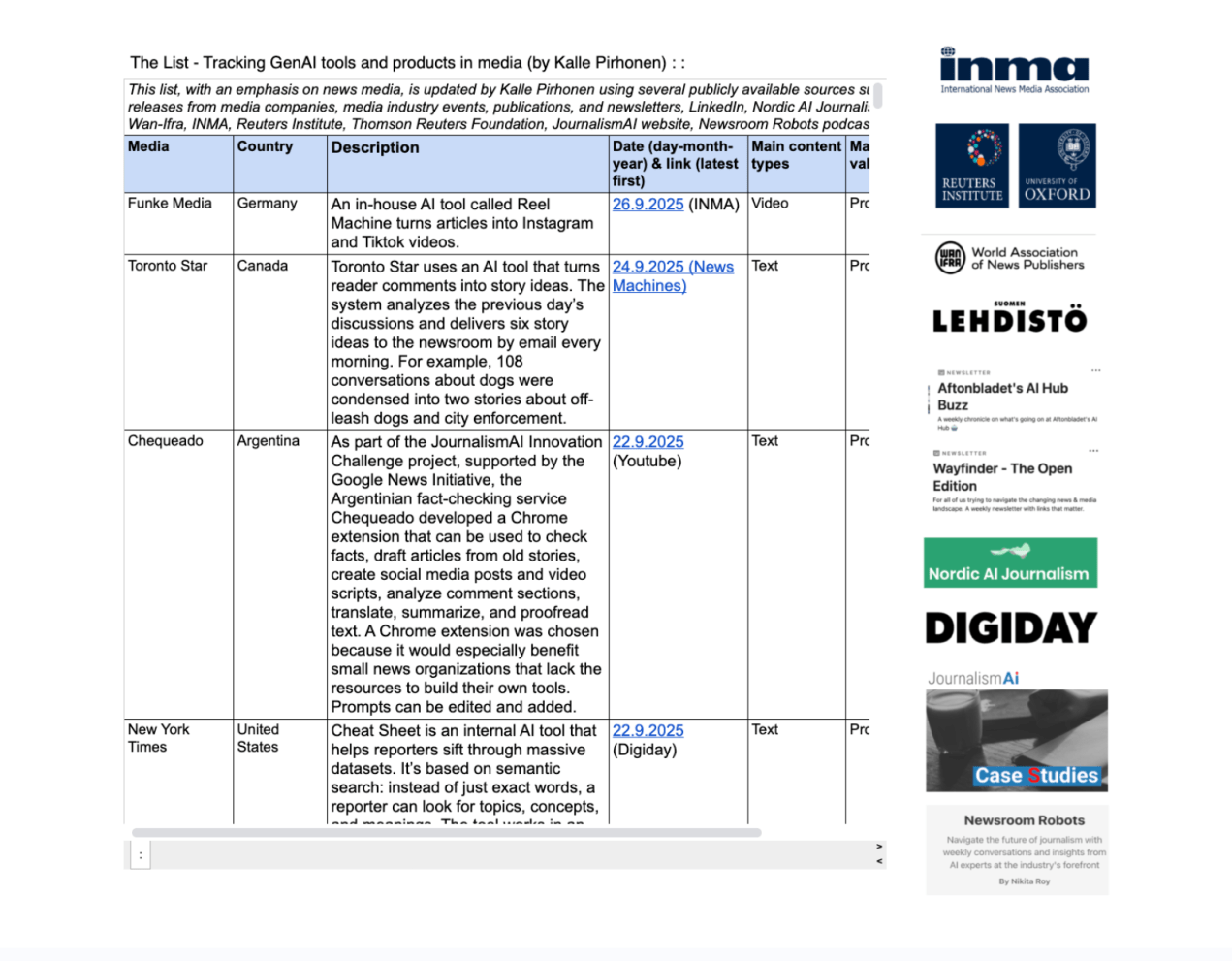

Toisaalta näyttää siltä, että joissain aihepiireissä toimituksellisten prosessien automatisointi on tietyllä tavalla turvallisempaa. Yksi pisimmälle vietyjä kokeiluja lienee tanskalaisen Better Collectiven alusta loppuun tekoälyllä pyörivä jalkapallon siirtouutissivusto.

Tasapainottelua

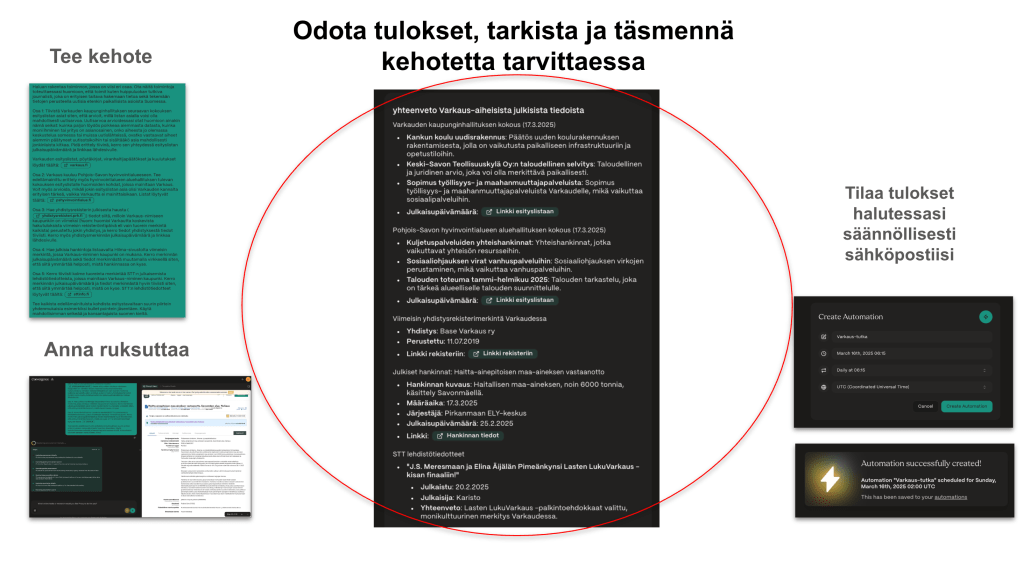

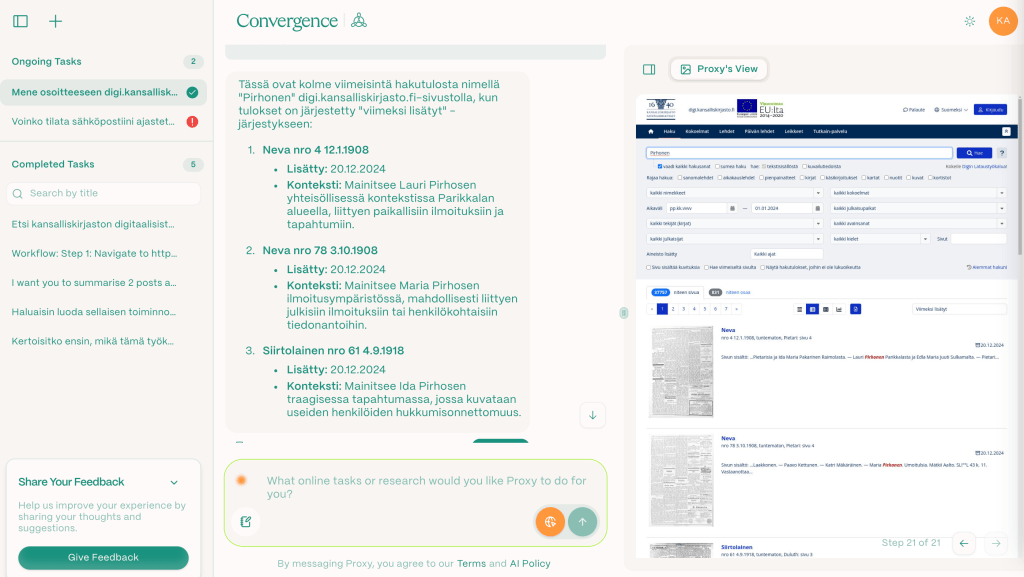

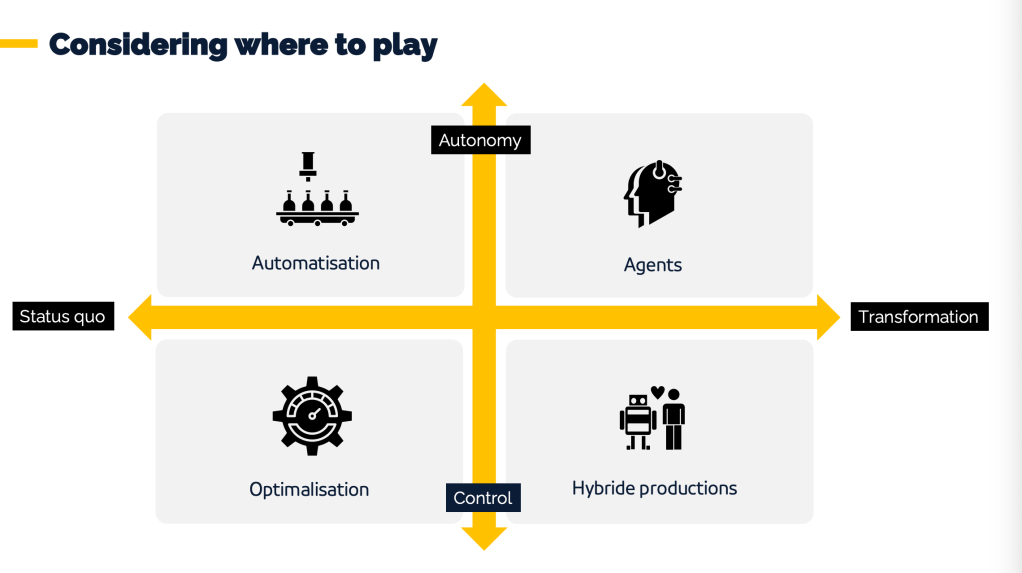

On sitten kyse pitkästä tai lyhyestä aikavälistä, tämä Ezra Eemanin nelikenttä tiivistää minusta hyvin, että kyse on jatkuvasta tasapainottelusta. Jos painopiste siirtyy automaatioon ja tekoälyagentteihin, se on väistämättä pois jos ei kontrollista niin vähintäänkin hallinnan tunteesta organisaatiossa.

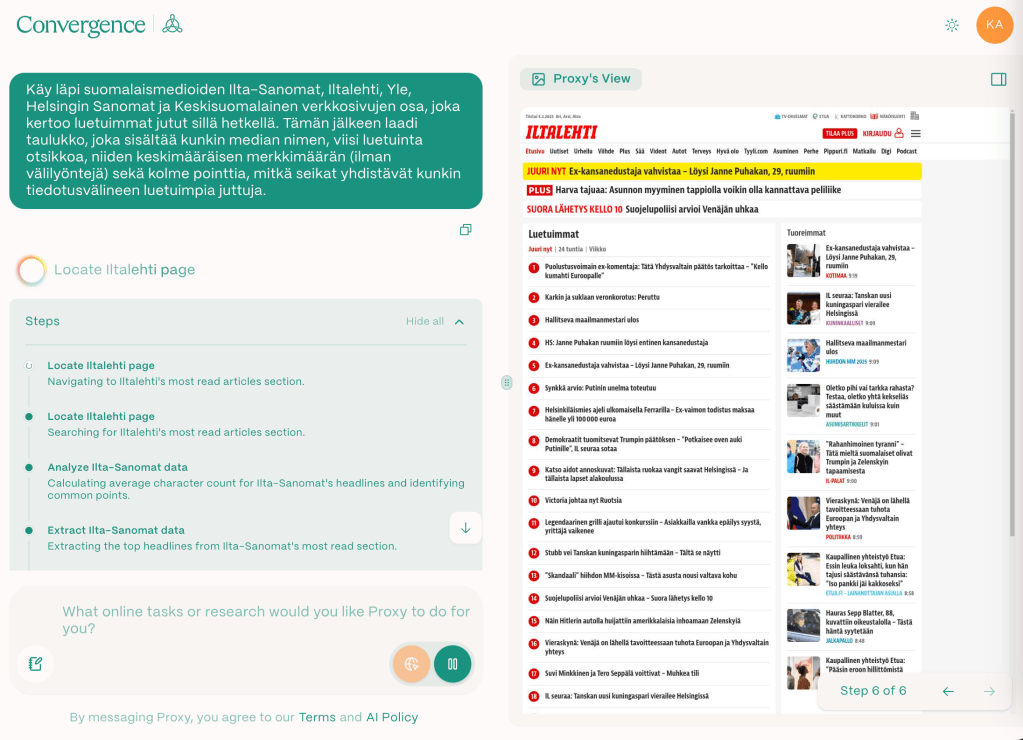

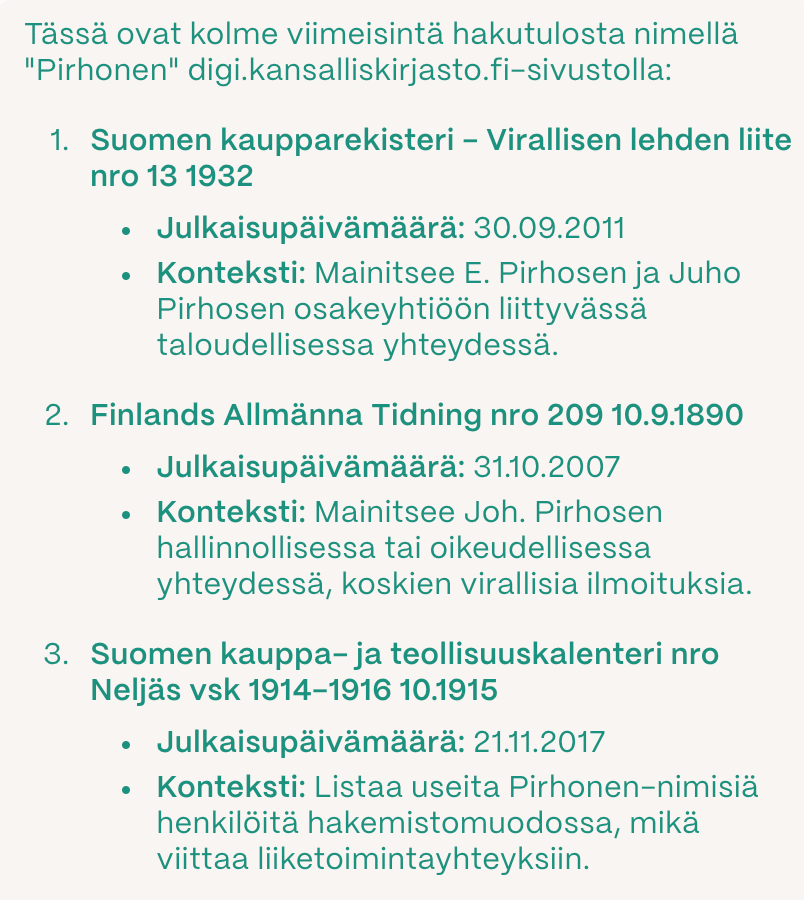

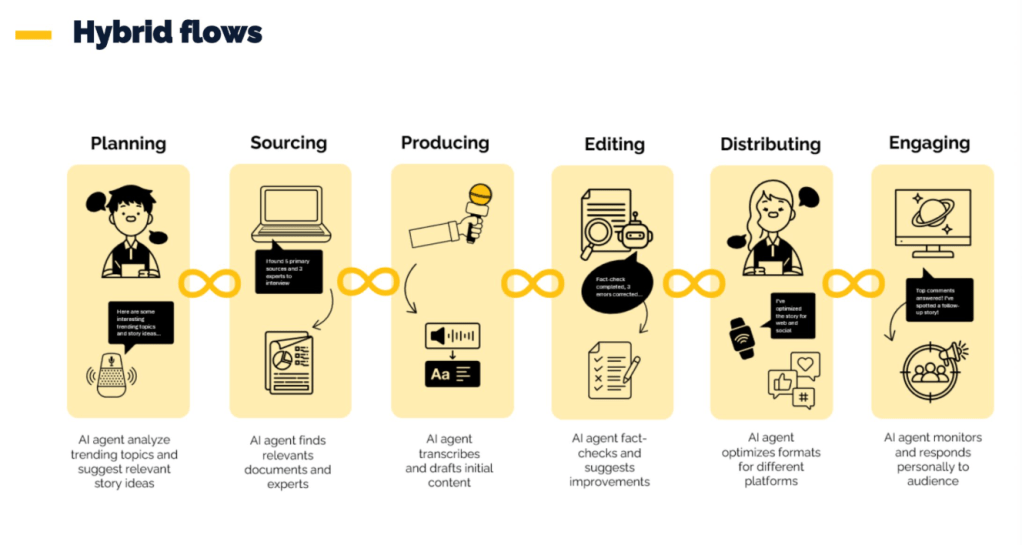

Tämä kuva tekoälyagenttien mahdollisuuksista mediassa on niin ikään Eemanin ja kiteyttää käytännössä, mistä esimerkiksi edellä mainitussa tanskalaisesimerkissä on kyse.

Eeman on Hollannin yleisradioyhtiö NPO:n strategia- ja innovaatiojohtaja ja Wan-Ifran eli sanomalehtien ja uutistoiminnan kustantajien maailmanlaajuisen kattojärjestön tekoälyneuvonantaja.

Lyhyt kaari – vuosi 2025

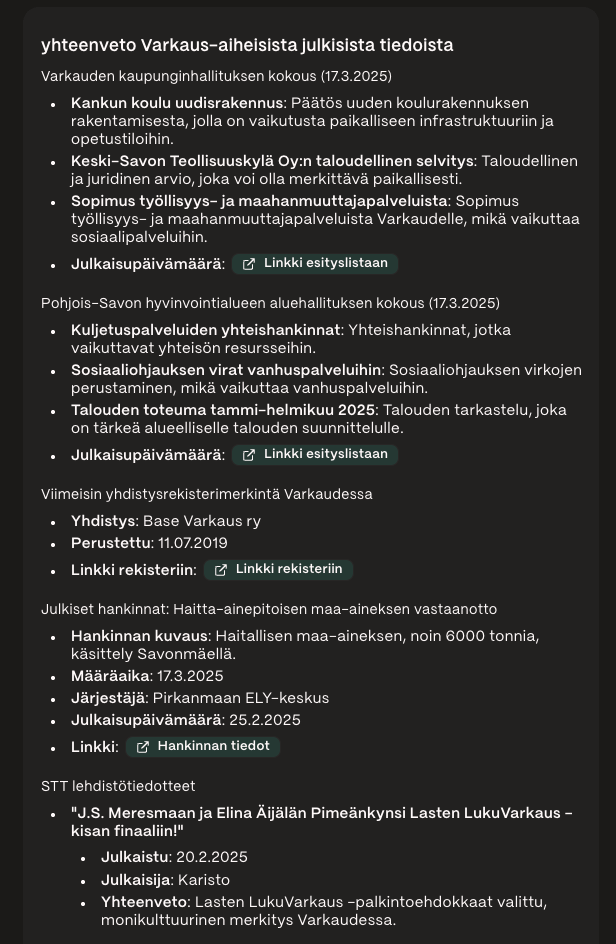

Tämän me jo tosiaan tiedämme. Tai ainakin tiedämme sen, mitä uutisorganisaatioiden johto on suunnitellut tämän vuoden aikana tekevänsä, ja millaisia tuloksia näistä olemme erilaisissa kansainvälisissä seminaareissa nähneet.

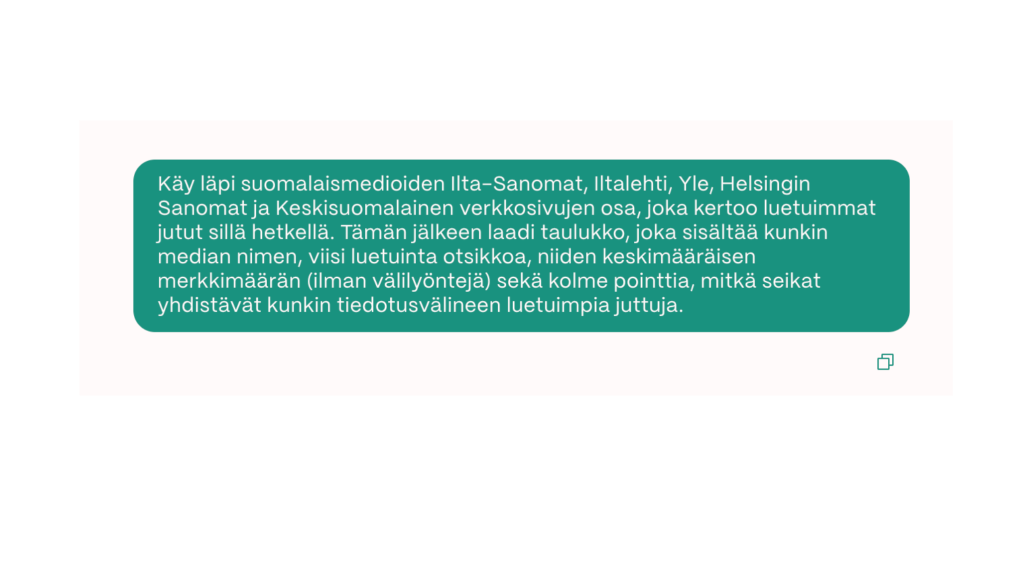

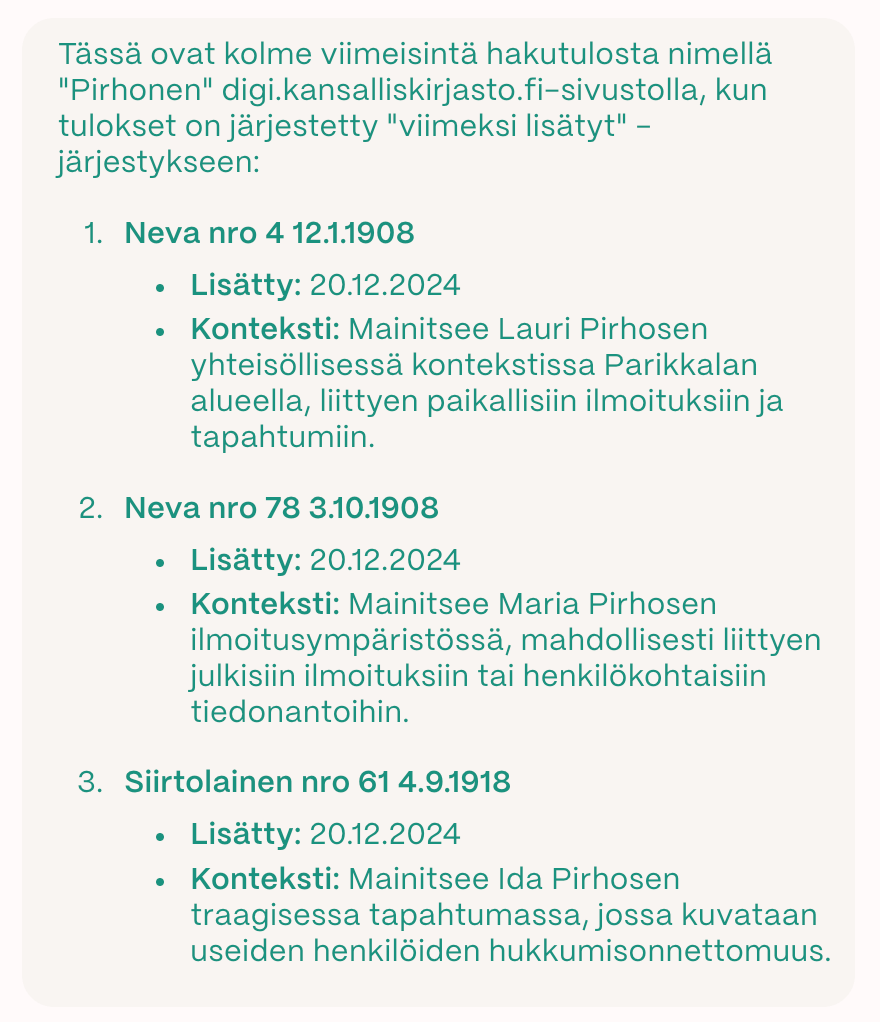

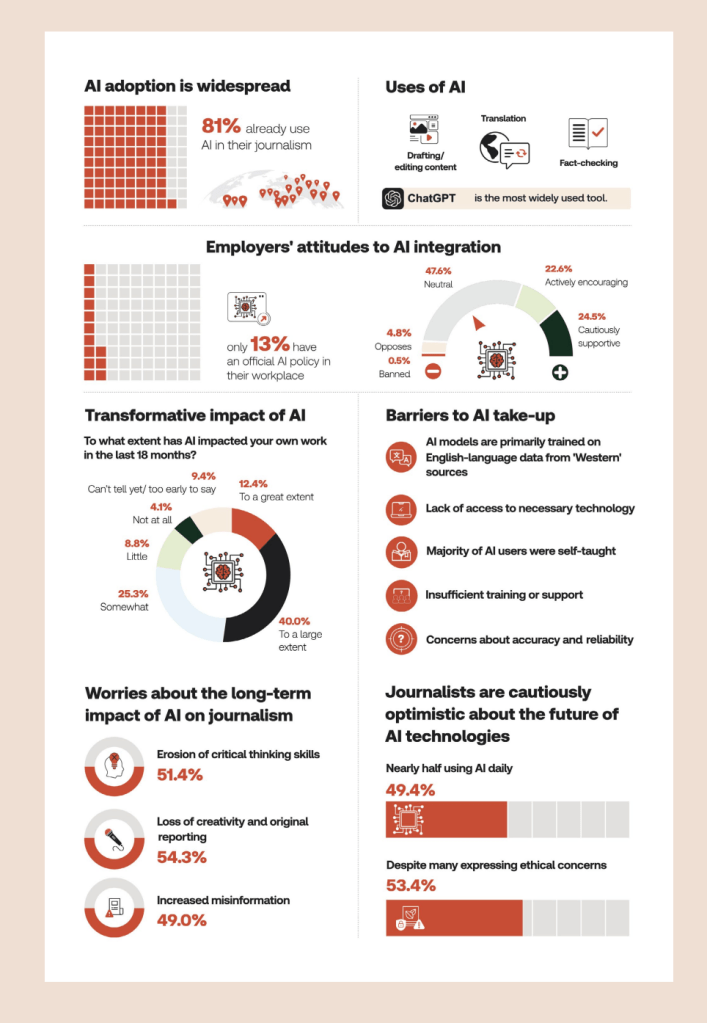

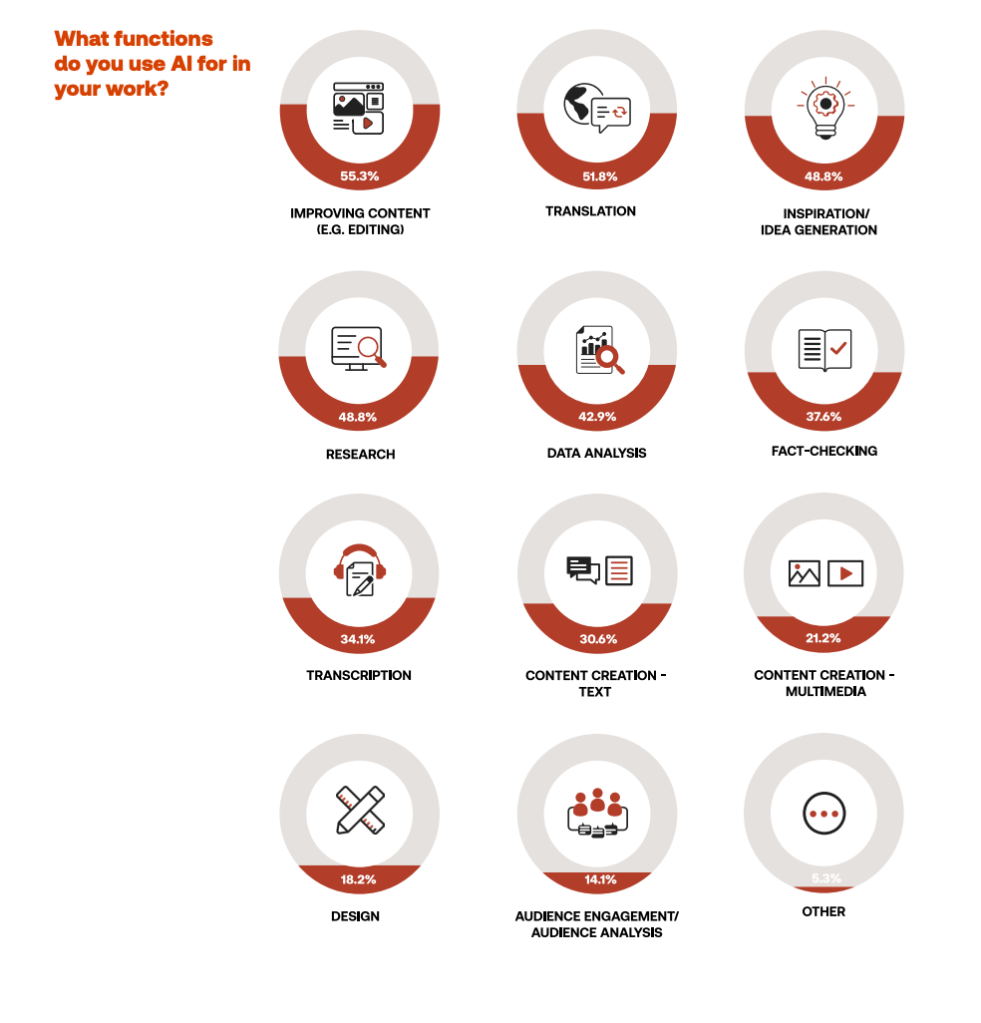

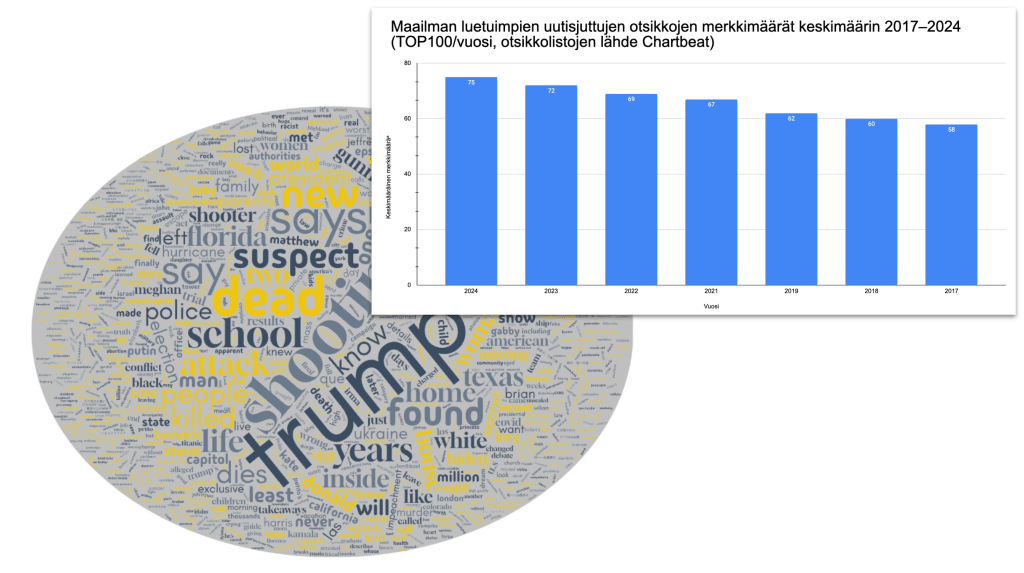

Ison kuvan piirtää Reuters-instituutin kyselytutkimus tammikuulta. Nämä kaksi kuvaa kertovat, mitä tapahtuu konepellin alla ja toisaalta mitä näkyy lukijoille.

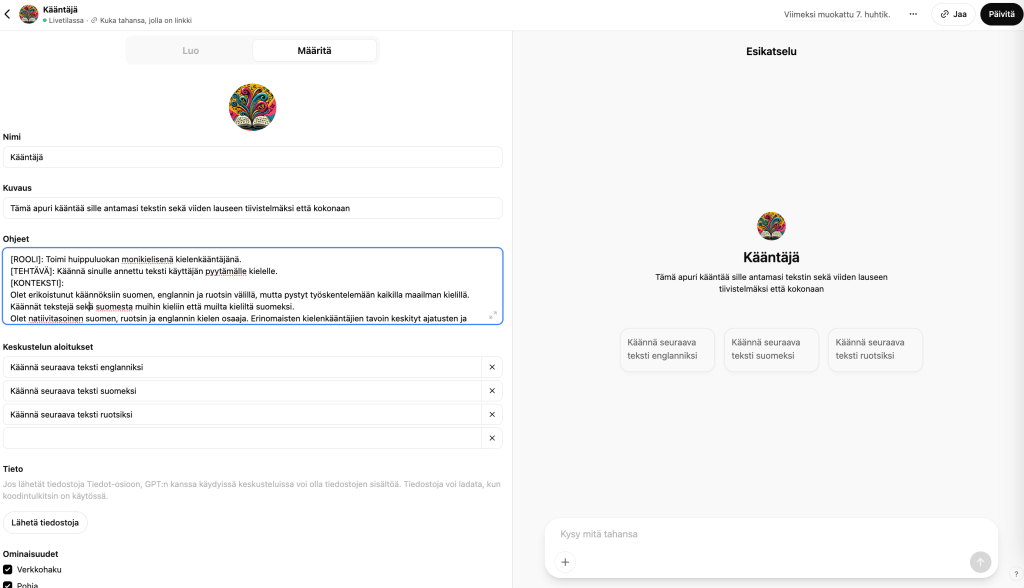

Monet mediat esimerkiksi kehittävät tai ovat jo tehneet työkaluja tiivistämiseen, kääntämiseen ja muuhun versiointiin, litterointiin, hakukoneoptimointiin, otsikointiin, yleisötarpeissa sparraamiseen, faktantarkistukseen, ideointiin, editointiin ja tiedonhakuun. Näkymä on monipuolistunut 1-2 vuodessa, kun ottaa huomioon, että alussa tekoälyllä lähinnä vain tiivistettiin ja käännettiin. Muutaman vuoden aikana osa näistä toiminnoista on jo uinut sinne missä toimittajat päivittäin muutenkin ovat: toimitus- ja suunnittelujärjestelmiin. Toimituksellisia prosesseja pyritään automatisoimaan yhä enemmän.

Asiakkaille yhä useammat uutistoimijat kehittävät keskustelevia käyttöliittymiä, mutta toistaiseksi epävarmaa on, kuinka iso massa niitä haluaa lopulta nimenomaan uutisten kuluttamiseen käyttää. Niiden käyttäminen kuitenkin vaatii tietynlaista aktiivisuutta käyttäjältään. Riskejäkin on. Suurin on se, jos luotettavan median botti antaa väärää tietoa.

Pitkä kaari – useampi vuosi

Tässä yhteydessä kuulee media-alalla aika usein termin ”liquid content”. Se on alun perin Googlen tekoälyjohtajan Mathieu Lorrainin keksimä termi. Tekoälyavusteinen perus-versiointi on jo nyt tätä. Tai Süddeutsche Zeitungin esimerkki, jossa jutun voi halutessaan klikata painikkeesta selkokieliseksi.

Joidenkin mielestä – ei kaikkien – edessä on täysin hyperpersonoitu tulevaisuus, jossa käyttäjä saa sisällön mieleisessään formaatissa automaattisesti ja ”artikkeli” sellaisenaan lakkaa olemasta. On hyvä tiedostaa, että media-alalla on ennustettu aiemminkin ties minkä kaikkien kuolemaa (esimerkiksi sanomalehtien, kun radio keksittiin), joten kaikkea ei kannata purematta niellä. Voi myös hyvin olla, että vanha ja uusi elävät joskus rinnakkain. Näinhän on nytkin.

Liquid content oli yksi teema, joka toistui jokin aika sitten Tanskassa järjestetyn Nordic AI in Media 2025 -tapahtuman puheenvuoroissa. Muitakin oli:

- Työkalujen käytöstä vapautuva aika käytettävä sellaiseen journalismiin, jota tekoäly ei voi kopioida tai automatisoida.

- Riippumattomuus teknologiajättien tekoälyalustoista: omat työkalut & integrointi toimitusten prosesseihin. Ei sulje pois yhteistyötä tekoälyjättien kanssa.

- Tarvitaan uusia liiketoimintamalleja, jotka eivät perustu vain mainoksiin ja tilauksiin.

- Tarvitaan kulttuurinmuutos toimituksiin: avoimuutta, kokeilunhalua, kykyä oppia. Ja aiempaa avoimempaa yhteistyötä medioiden välillä. Jopa toistensa kanssa kilpailevien medioiden.

Mikä on lopulta olennaista?

Kaiken kohinan keskellä huomaan itse ajattelevani usein…niin, tätä kaikkea loputonta kohinaa ja hälinää. Ja luovuutta. Miten nähdä sen keskeltä olennainen? Tämähän liittyy keskeisesti myös journalistiseen työhön. Uskon vahvasti, että tekoäly pystyy jossain vaiheessa aidosti säästämään ihmisten aikaa, jotta nämä voivat todellakin keskittyä niin sanottuun olennaiseen (journalismissa sellaiseen sisältöön jota on vaikeinta kopioida), mutta muutos on hitaampi kuin kuvittelemme. Tämän puki tällä viikolla erinomaisen hyvin sanoiksi Jukka Niittymaa, joka on yksi Suomen arvostetuimmista tekoälyasiantuntijoista:

”Aluksi luulin, että generatiivinen tekoäly vapauttaa meidät pahimmasta kiireestä. Enää en luule niin. Tekeminen muuttuu, mutta oli lapsellista olettaa, että ihmisluonto muuttuisi yhtä nopeasti kuin tekniikka kehittyy. Jos me haluamme pitää huolta siitä, että ihmisellä on sellaisia ideoita, mitä tekoäly ei ehkä kykene vielä generoimaan ja hallusinoimaan, niin ajattelun aikaa pitäisi alkaa arvostamaan. Mutta mitenkäs se temppu tehdään maassa, jossa innovoinnin tehokkuutta mitataan monissa paikoissa innovoidessa ja asiantuntijatöissä kellokorttimaisesti tuntikatteella?”